Danneggiamento e perdita dei dati¶

Principali cause della perdita dei dati¶

I dati digitali possono essere persi se l’unica copia di un mezzo digitale viene rubata o perso in un incendio, e questo fatto è comune anche alle copie cartacee o ai negativi. Quindi qui parleremo degli altri modi di perdita dei dati digitali, riconducibili grosso modo alle seguenti aree di interesse:

Il deterioramento fisico del supporto (tutti i supporti si rovinano a velocità diverse)

Errori di trasmissione non rilevati durante il trasferimento dei dati

La mancanza di supporto a lungo termine per i formati digitali proprietari

Hardware obsoleto

Kroll Ontrack, la più grossa compagnia mondiale nel recupero dati, ha delle statistiche interessanti su cosa causi veramente la perdita dei dati.

Causa della perdita di dati |

Percezione |

Realtà |

|---|---|---|

Problemi hardware o di sistema |

78% |

56% |

Errore umano |

11% |

26% |

Danneggiamento software o problema |

7% |

9% |

Virus informatici |

2% |

4% |

Disastro |

1-2% |

1-2% |

Analizziamo questi casi uno alla volta.

Deterioramento del supporto di memorizzazione¶

I dispositivi di seguito elencati sono ordinati per velocità di accesso ai dati, dal più lento al più veloce.

Supporti magnetici¶

I nastri magnetici sono comunemente usati nei sistemi di backup (copia di sicurezza) professionali, ma molto raramente nei sistemi casalinghi. I nastri hanno problemi con la conservazione dei dati a lungo termine, possono essere danneggiati dai campi magnetici intensi, e la tecnologia dei nastri cambia in continuazione. Tuttavia, i nastri sono più sicuri in alcuni casi rispetto ai dispositivi ottici: sono meno soggetti a graffi, sporco e a errori durante la scrittura. Per evitare problemi con la conservazione a lungo termine, i nastri devono essere ricopiati ogni 5-8 anni, altrimenti si rovineranno per la protezione dei codici di controllo. L’aspetto negativo dei nastri magnetici è che i dispositivi a nastro sono costosi e il tempo di ripristino dei dati può essere 20 volte più lungo di quello di un disco rigido. I sistemi di backup a nastro sono utilizzati al meglio nelle grandi realtà professionali che richiedono grandi quantità di backup di dati.

Dispositivi ottici¶

Ti potrebbe sorprendere sapere che molti CD-R si deteriorano fisicamente a una velocità maggiore delle pellicole. Mentre una pellicola potrebbe deteriorarsi in decenni rispetto ad alcuni supporti ottici, i dispositivi digitali di cui viene regolarmente eseguita una copia di sicurezza non perdono mai nulla. La pellicola inizia a deteriorarsi nel momento in cui viene creata e sviluppata, gli 0 e 1 digitali no. La pellicola non avrà mai lo stesso colore e contrasto di quando è stata creata, il supporto digitale sì. Tuttavia, il supporto digitale è soggetto ad alterazione.

Tutti i dispositivi ottici sono soggetti a errori, anche se scritti di recente. Questo è il motivo per cui vengono protetti con codici di correzione errori che assorbono fino al 25% del reale spazio sul disco. Ma nonostante questa notevole quantità di protezione subiscono comunque un deterioramento derivante da invecchiamento chimico, esposizione ai raggi ultravioletti, graffi e polvere, ecc.

Non si dovrebbe fare affidamento al CD e al DVD medio, trattato in modo corretto, per non più di pochi anni. È possibile comprare CD e DVD con qualità da archivio molto più durevoli, ma sono più difficili da trovare e anche più costosi. In giro si trovano offerte per dispositivi ottici placcati in oro a pochi euro il pezzo, tacciati di durare fino a 100 anni (se ci credi).

Prima o poi, tutti i dischi ottici diventeranno illeggibili, ma puoi ridurre il rischio usando dischi e masterizzatori di buona qualità, conservando il disco nel modo appropriato. I migliori masterizzatori ottici non sono molto più costosi di quelli più economici, ma scrivono in modo molto più affidabile. Il problema è scegliere quello giusto.

Per i dispositivi ottici danneggiati, Wikipedia fa un elenco di tutte le applicazioni più comuni progettate per recuperare di dati da floppy disk e hard disk danneggiati, dispositivi flash tipo le memorie delle fotocamere e i dispositivi USB, e via discorrendo.

Un disco Blu-ray multimediale ottico a doppio strato può contenere 50 GB, quasi sei volte la capienza di un DVD doppio strato da 8,5 GB. Tutto quello che è stato detto per i CD e i DVD vale anche per i dischi Blu-ray.

Pratiche migliori: masterizza i supporti ottici, con un buon masterizzatore, su un supporto di qualità «archivio» in un formato aperto (non proprietario). Verifica i dati; etichettali con un testo descrittivo più data e autore. Chiudili in un luogo pulito, buio, asciutto e senza animali. E non dimenticarti di copiarli sulla prossima generazione di supporti prima di gettare il tuo ultimo pezzo di hardware o di software in grado di leggerli.

Dischi fissi¶

I produttori di dischi fissi (HDD) tengono le loro statistiche riservate. La garanzia di un produttore ti permette di rimpiazzare il disco, ma non i dati. La garanzia di un produttore ti acquista un disco nuovo, ma non vi sono dati su quando esso potrebbe durare. Il servizio di storage Backblaze ha riportato un tasso di errore del 1,5% annuo nel 2023 basato su un inventario di 237.278 dischi rigidi. Google ha studiato in larga scala le rotture meccaniche degli HDD: Disk Failures study.

In breve: la durata dei dischi è maggiore quando funzionano tra i 35° e i 45°C. Potrebbe essere contro-intuitivo ma il tasso di errore dei dischi rigidi aumenta drasticamente alle temperature più basse. I componenti del controller (elettronici) sono la principale causa di guasti e una fonte di errore che SMART non diagnostica. Alcuni errori SMART sono indicativi di un guasto imminente, in particolare errori di tipo «scan» e «relocation counts». L’aspettativa di vita media è di 4-5 anni.

In generale, e contrariamente a considerazioni di tipo intuitivo ed ecologiche, tenere continuamente acceso un disco fisso, anziché accenderlo e spegnerlo in continuazione, aumenta il suo ciclo di vita. È stato anche segnalato che il ciclo di vita degli HDD può essere ridotta da una gestione aggressiva dell’energia, che riduce in modo rapido la rotazione del dispositivo. I fattori peggiori per gli HDD sono dunque probabilmente le vibrazioni, gli shock e le temperature fredde.

Se il tuo HDD inizia a fare strani rumori, il normale recupero di file tramite software non sarà di aiuto. Fai velocemente una copia di sicurezza. Usa l’accessorio dd se possibile, non un comune programma di backup, dato che dd legge il flusso dati in modo dolce e a spirale, dall’inizio alla fine, e non sollecita la meccanica. Esistono compagnie specializzate per il recupero dati da un disco altrimenti guasto, ma il processo è molto costoso.

La suite SmartMonTools Linux ti permette di interrogare i dispositivi hardware di memorizzazione alla ricerca di guasti futuri. Raccomandiamo caldamente l’uso di questo tipo di strumenti sul tuo computer.

Dispositivi a stato solido (SSD)¶

Gli SSD sono meccanicamente più robusti e molto più veloci degli HDD. Gli SSD stanno sostituendo gli HDD per capacità, e il prezzo è diventato più competitivo, rendendoli una soluzione sempre migliore come dispositivi di memorizzazione permanente dei dati.

Il fornitore di storage Backblaze ha riportato un tasso di errore del 1% annuo nel 2023 basato su un inventario di 3.144 SSD. Gli SSD sono dunque migliori degli HDD, ma tuttavia non affidabili al 100%.

Quando gli SSD sono utilizzati come dispositivo esterno, una delle maggiori cause di perdita di dati (spesso recuperabile) è la rimozione non sicura del SSD dal computer. Prima che i dati siano trasferiti dalla memoria del computer ai dispositivi collegati, essi sono memorizzati per qualche tempo in una memoria tampone. Nei dischi fissi questo tempo è al più di secondi, mentre negli SSD può arrivare a decine di minuti. Quindi, prima di scollegare il tuo dispositivo accertati che i buffer dei dati siano stati trasferiti utilizzando le capacità del tuo sistema operativo (rimozione sicura del dispositivo).

Memoria non volatile (NVM)¶

NVM Express (NVMe), per la Non-Volatile Memory, è un’interfaccia di dispositivo logico per l’accesso a un dispositivo multimediale di memorizzazione non volatile collegato a un bus PCI Express (PCIe). Utilizza la medesima e velocissima memoria flash NAND utilizzata negli SSD, ma usa un’interfaccia a scheda M.2 al posto di quella mSATA, più lenta, utilizzata con gli HDD più vecchi.

NVMe consente di ospitare hardware e software in modo da sfruttare a pieno i livelli di parallelismo possibili nei moderni SSD. NVMe riduce gli overhead di I/O apporta diversi miglioramenti di prestazioni relative ai predecessori SSD. I protocolli di interfaccia mSATA furono sviluppati per l’uso con gli HDD decisamente più lenti, in cui esiste un ritardo decisamente lungo tra una richiesta e un trasferimento di dati, e in cui le velocità dei dati sono molto più lente di quelle RAM.

Dato che i dispositivi NVMe utilizzano lo stesso hardware degli SSD per memorizzare i dati, la loro affidabilità deve essere simile.

Importante

In ogni caso, gli SSD o i NVMe, in quanto dispositivi interni, sono la soluzione più moderna ed efficiente per ospitare le banche dati e le raccolte immagini di digiKam.

Guasti di alimentazione elettrica¶

Sbalzi di corrente¶

Quasi l’1% di tutti i computer è colpito dai fulmini e da sbalzi di corrente ogni anno.

Questa sezione tratta della perdita totale di dati dovuta a sbalzi di corrente. Naturalmente ti potrebbero capitare delle perdite occasionali di dati dovute a un blackout durante il salvataggio dei file. Ma questo genere di perdite può essere recuperato senza grosse difficoltà.

Non devi aspettare la prossima tempesta di fulmini per preoccuparti di come le improvvise variazioni di corrente possano danneggiare il tuo computer. Statistiche recenti hanno dimostrato che i guasti ai componenti elettronici sono dovuti al 63% da problemi elettrici, e che i computer sono soggetti da due a tre anomalie di alimentazione al giorno. Dato che gli sbalzi e i blackout non sono preannunciati, la cosa sensata è proteggere il tuo computer con qualche sorta di dispositivo di protezione dagli sbalzi di corrente.

Come avvengono gli sbalzi di corrente¶

Uno sbalzo si verifica quando il voltaggio dell’impianto aumenta al di sopra del valore nominale per più di 10 millisecondi. Il 60 percento di tutti gli sbalzi avvengono all’interno della casa e dell’ufficio, generalmente quando un apparecchio con un motore (come un’asciugatrice, un frigo o una pompa idraulica) si spegne, e la potenza che stava utilizzando è dirottata altrove come sovratensione. Il rimanente 40 percento degli sbalzi sono invece causati da fattori quali i fulmini, lo spegnimento delle griglie elettriche, i salti della linea, un cattivo impianto e così via.

Mentre la maggior parte dei dispositivi elettrici non viene danneggiata dagli sbalzi, i dispositivi che si basano su chip per computer e microprocessori ad alta velocità sono suscettibili a seri danni. Le anomalie di corrente che raggiungono il tuo PC possono mandare in blocco la tastiera, causare perdite complete di dati, degradare l’hardware, danneggiare la scheda madre e altro ancora. Non riuscire a proteggersi dall’inevitabile può causare una perdita di tempo e di denaro.

Scaricatore di sovratensioni (SPD)¶

La difesa più comune dagli sbalzi è un dispositivo chiamato scaricatore di sovratensioni (SPD, Surge Protector Device), un dispositivo che lavora assorbendo gli eccessi di energia che vengono dirottati nella messa a terra. Comunemente si trovano sotto forma di prese multiple (uno di quei dispositivi con 5-6 attacchi e una spina singola con la messa a terra). Tieni presente che non tutte le prese multiple funzionano da SPD.

Quando scegli il tuo SPD, controlla che sia certificato con lo standard UL 1449, che garantisce una certa soglia di protezione minima. Dovresti anche cercarne uno che funga da protezione contro i fulmini (non tutti lo fanno) e che garantisca, tramite un’assicurazione, i dispositivi ad esso collegati correttamente.

Siccome gli sbalzi di corrente possono seguire qualsiasi strada verso il PC, accertati che ogni periferica collegata ad esso sia protetta a sua volta. Questo include la linea telefonica o il modem via cavo, in quanto lo sbalzo di corrente può giungere anche attraverso questa strada. Diversi produttori stanno producendo SPD che possiedono sia uscite per la presa di corrente sia per il doppino telefonico per il modem, mentre altre possiedono ingressi per i cavi coassiali per chi utilizza il modem via cavo o una scheda di sintonizzazione TV.

Se possiedi un portatile, sarebbe bene dotarti di un SPD. Esistono diversi SPD in commercio, progettati specificamente per i portatili, piccoli e con uscite sia per la presa di corrente sia per il doppino telefonico: sono ideali nei viaggi.

Gruppo di continuità (UPS)¶

Sebbene un SPD protegga il tuo sistema dalle fluttuazioni minori della linea elettrica, nulla potrà in caso di blackout di corrente. Persino una mancanza di soli pochi secondi può causare perdite di dati di notevole valore: potrebbe valere la pena di investire in un **gruppo di continuità* (detto anche UPS, Uninterruptible Power Supply).

Oltre a funzionare come SPD, questi dispositivi passano automaticamente all’alimentazione a batteria quando si verifica una mancanza di corrente, dandoti l’opportunità di salvare i dati e di spegnere correttamente il PC. Alcuni modelli ti consentono persino di continuare a lavorare fino a quando non torna la corrente. Quando acquisti un UPS, assicurati che abbia le stesse qualità che cercheresti in un SPD, ma verifica anche la vita della batteria e il software incluso.

Considerando il rischio potenziale cui è esposto il tuo sistema, adottare misure di sicurezza contro i disturbi della rete elettrica è un investimento valido. Un SPD di qualità o un UPS da 500 W non costa poi così tanto rispetto alla tranquillità che acquisiresti sapendo che il computer è ben protetto. Per lo meno, valuta di staccare tutti i cavi del tuo computer quando vai in vacanza.

Politica di salvaguardia¶

Servizi web di memorizzazione¶

Amazon Web Services include S3 (Simple Storage Service, “Servizio Semplice di Memorizzazione”). Con la giusta configurazione puoi montare S3 come un disco su sistemi Linux, Mac e Windows, permettendoti di utilizzarlo come destinazione per le copie di sicurezza dei tuoi software programmi. Google Drive è un altro popolare servizio di storage in cloud in cui è possibile salvare una quantità infinita di dati.

Lo storage in cloud è costoso rispetto a un disco fisso casalingo. Inoltre devi trasferire le immagini il sistema, relativamente lento rispetto a quello locale, di Internet. Noi pensiamo, però, che il salvataggio in cloud sia un sistema di salvaguardia utile contro la perdita di dati localizzata delle immagini più essenziali.

Google Foto e Flickr forniscono servizi di salvataggio in rete che sono specializzati per le fotografie. Il loro spazio gratuito è limitato, dunque non vorrai memorizzare in rete le immagini ad alta risoluzione. Gli account a pagamento offrono però più spazio di salvataggio.

Le soluzioni basate sul web sono probabilmente davvero sicure, in termini di conservazione dei dati. Gli errori di trasmissione vengono corretti automaticamente (grazie al protocollo TCP) e le grandi compagnie di solito fanno copie di sicurezza più una memorizzazione distribuita, in modo da essere loro stesse a prova di disastro.

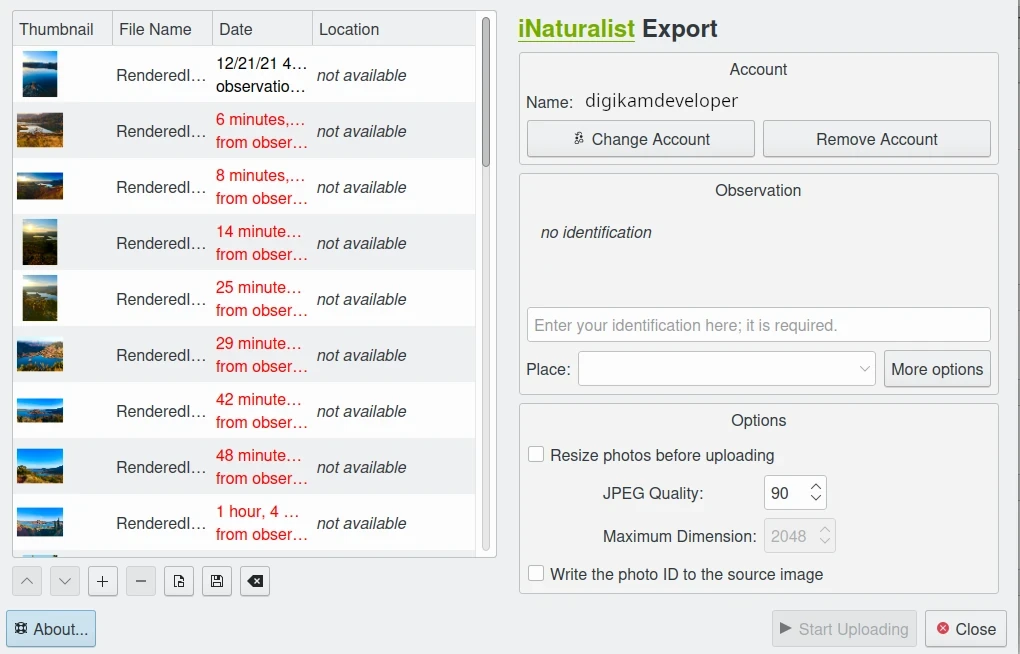

digiKam fornisce uno strumento per esportare elementi nel servizio web iNaturalist¶

Errori di trasmissione¶

La perdita di dati non capito soltanto nei dispositivi di salvataggio, i dati possono venir persi anche quando viaggiano all’interno del computer o nella rete (sebbene lo stesso traffico di rete sia protetto dagli errori tramite il TCP). Gli errori si generano occasionalmente nei BUS interni dei computer e nei chip di memoria. L’hardware di largo consumo non ha protezione contro gli errori di bit casuali, ma la tecnologia per monitorare e correggere gli errori esiste. Puoi comprare memorie protette ECC (error code correction), che funzioneranno con una scheda madre che supporta ECC, sebbene siano costose. Con la RAM ECC almeno la memoria sarà monitorata per errori singoli sui bit e corretta. Gli errori a doppio bit potrebbero sfuggire al rilevamento, ma capitano davvero raramente per doversene preoccupare.

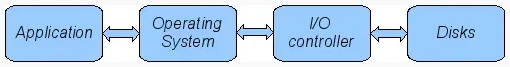

Il flusso di lavoro dei dati tra applicazione e multimedia di memorizzazione¶

Il diagramma descrive la catena di trasmissione di un elemento in un computer: tutti i passaggi sono suscettibili a errori di trasmissione. I file system ZFS e BTRFS Linux sono progettati per assicurare l’integrità del sistema operativo al percorso al disco sotto Linux.

Il tasso di errore di bit (BER) per la memoria e nei canali di trasmissione è nell’ordine di 1 su 1 trilione (1E-12 per bit). Ciò significa che 1 su 3000 immagini da 30 megabyte contiene un errore dovuto a un problema di trasmissione. Ora, quanto questo sia drammatico per un’immagine è lasciato al caso. Potrebbe significare che l’immagine sia distrutta o che un solo pixel viene cambiato di valore da qualche parte. Ma a causa della compressione dati usata su quasi tutte le immagini, è impossibile predire l’impatto di un errore di un singolo bit.

La cosa peggiore è che probabilmente non compariranno avvisi da parte del tuo computer quando si verifica un errore di trasmissione o di memoria. Tutti questi difetti si verificheranno indistrubati, fino al giorno in cui apri l’immagine e ti accorgi che è rovinata. È preoccupante che non ci sia una protezione per gli errori di trasmissione nel computer. È sorprendente che il protocollo di trasmissione Internet TCP sia molto più sicuro per trasferire dati rispetto a quello che viene usato all’interno di un computer.

Gli alimentatori inaffidabili sono un’altra sorgente di perdita di trasmissione, perché generano interferenze con il flusso dei dati. Con molti filesystem normali, questi errori possono non essere notati.

Futuro dei filesystem¶

ZFS di Oracle sembra essere uno dei due candidati per gestire gli errori del disco a basso livello, ed è estremamente scalabile. È open source, eccessivamente brevettato, distribuito con una licenza incompatibile con GPL, ed è disponibile sui sistemi Linux e macOS.

Oracle ha introdotto il suo filesystem BTRFS. Impiega le stesse tecniche di protezione di ZFS ed è disponibile in Linux.

Errori umani¶

Furti e incidenti¶

Non sottovalutare il potenziale dei dati persi per furto o incidente. Questi due fattori rappresentano la perdita di dati per l’86% dei portatili e il 46% dei sistemi desktop. Per i portatili il furto costituisce, da solo, il 50% dei casi.

Malware¶

Le perdite di dati dovute ai virus sono meno gravi di quanto la comune saggezza faccia ritenere. Esse rappresentano meno danni del furto e delle re-installazioni, per esempio. Mentre il malware sembra limitato principalmente agli utenti dei sistemi operativi Microsoft, la frequenza di attacchi sui sistemi Linux e Apple è in crescita.

Errore umano e perdita di dati¶

L’errore umano, come in ogni cosa, è il maggiore fattore coinvolto nella perdita dei dati. Le persone fanno cose davvero stupide. Gli utenti esperti estrarranno il disco sbagliato dal RAID o lo riformatteranno, distruggendo tutte le informazioni al suo interno. Agire senza pensare è pericoloso per i tuoi dati.

Quando qualcosa va male, fai un bel respiro e non andare in panico. L’approccio migliore è fare un piano prima di intraprendere qualsiasi azione che potrebbe causare una perdita di dati importante. Siediti e spiega il piano a una persona inesperta. Sarai sorpreso di quanti errori stupidi possono essere evitati semplicemente creando un piano e spiegandolo a qualcun altro.

Se il tuo disco inizia a fare rumori strani, un normale programma di recupero file non essere di aiuto. Esegui una copia di sicurezza rapida. Se il disco sta ancora girando e non riesci a trovare i dati, cerca un programma di recupero dati e fai una copia di sicurezza in un altro computer o dispositivo. Una soluzione avanzata e universale potrebbe essere utilizzare la suite open source CloneZilla. La cosa importante è scaricare i tuoi dati in un altro dispositivo, o computer, oppure in una chiavetta USB o disco fisso. È quindi sempre buona pratica salvare i dati recuperati in un altro disco. Lo strumento dd è il mezzo più adatto nei sistemi Linux.

Falsi miti diffusi¶

Ci piacerebbe sfatare alcuni miti diffusi:

I filesystem open source sono meno soggetti alla perdita di dati rispetto a quelli proprietari. Sbagliato: NTFS è, sebbene di poco, migliore di ext4, ReiserFS, JFS, XFS, solo per nominare alcuni dei filesystem più popolari utilizzati spesso dalle distribuzioni come formato predefinito di memorizzazione.

I filesystem con il journaling dei file prevengono la corruzione e la perdita dei dati. Sbagliato: sono solo in grado di velocizzare il processo di scansione in caso d’interruzione improvvisa della corrente, e di prevenire gli stati ambigui. Ma se un file non era stato interamente salvato prima dell’incidente sarà perso.

I sistemi RAID prevengono il danneggiamento e la perdita dei dati. Per lo più sbagliato. Il RAID 0 tracciano i dati senza ridondanza, dunque in realtà ti espongono maggiormente alla perdita di dati. RAID 1 scrive i dati con mirror, dunque previene la perdita di dati nel caso di errori di lettura di un singolo disco, ma non altri errori. RAID 5 può proteggerti anche dalla perdita di dati nel caso di guasto del disco, ma non dagli errori del controller RAID o del filesystem. Molti controller RAID economici (come la maggior parte di quelli integrati sulla scheda madre) non segnalano i problemi, pensando che non li noterai mai. Se te ne accorgi dopo diversi mesi, che possibilità hai di sapere che il problema era del controller? Un problema insidioso è il danneggiamento della parità dati su RAID 5: è abbastanza semplice controllare un file leggendolo e confrontandolo con i metadati. Controllare la parità dati è molto più difficile, perciò non vedrai gli errori di parità fino a quando non ricostruirai il filesystem. A quel punto sarà, ovviamente, troppo tardi.

I virus sono la più grossa minaccia per i dati. Sbagliato: il furto e gli errori umani sono la causa principale della perdita dei dati.

Stima dello spazio di memorizzazione¶

I sensori delle fotocamere digitali sono uno o due rapporti focali (stop) distanti dalle limitazioni fisiche fondamentali del rilevamento della luce. Vogliamo dire questo: man mano che la tecnologia progredisce, esiste un limite naturale al suo avanzamento. Le caratteristiche di sensibilità e rumore per ogni tipo di sensore di luce non sono lontani da quel limite.

Le fotocamere moderne tendono verso i sensori da 50 megapixel, sebbene questa risoluzione non sia necessariamente evidente nel risultato finale. Data la dimensione del sensore e la qualità dell’ottica, 12 megapixel sono un valore ottimale per le fotocamere compatte. Anche le reflex digitali arrivano ai propri limiti a circa 20-24 megapixel, per risoluzioni più alte bisogna passare a sensori full frame (24x36 mm) o di formato ancora maggiore.

Dunque, prendendo per buona la propaganda dei produttori riguardo i megapixel, è possibile affermare che il grosso delle fotocamere future supporterà meno di 30 megapixel. Questo fornisce una base per la stima dello spazio di stoccaggio richiesto per ogni foto futura: meno di 40 MB per immagine. Anche se viene introdotta la gestione delle versione (raggruppamento delle variazioni di una fotografia sotto un solo file di riferimento), la tendenza è registrare solo le istruzioni utilizzate per produrre la nuova versione, in modo che sia necessario registrare solo una piccola quantità di dati anziché l’intera copia, per ogni versione dell’immagine.

Per stimare la quantità di spazio memorizzazione da pianificare, determina semplicemente il numero di fotografie che scatti ogni anno (semplice con la barra laterale della linea temporale di digiKam) e moltiplicalo per 40 MB. La maggior parte degli utenti manterrà meno di 2000 immagini per ciascun anno, il che equivale a meno di 80 GB/anno. Presupponendo che cambierai il tuo disco rigido (o qualsivoglia supporto in futuro) ogni 4-5 anni, l’aumento naturale delle capacità di memorizzazione ti dovrebbe essere sufficiente per restare al passo con i requisiti di spazio di memorizzazione.

I fotografi ambiziosi che richiedono più spazio, probabilmente molti di più, dovrebbero considerare di acquistare un server di file. Giga-Ethernet viene integrata nelle schede madri e il trasferimento dei file in una rete locale può essere velocissima. Se non hai bisogno di molti dati, dovresti prendere in considerazione le moderne schede madri con supporto per gli SSD veloci. Pochi terabyte di SSD veloce connesso tramite una porta Thunderbolt 5 può far letteralmente volare la tua raccolta di immagini.

Copie di sicurezza e recupero¶

Il 6% di tutti i PC subirà un episodio di perdita di dati per ogni anno di vita. Sei stato avvertito, dunque non incolpare nessun altro se dovesse capitare un guasto al tuo supporto di memorizzazione. Gli HDD e gli SSD di svariati terabyte non sono molto costosi. Comprane uno e usalo per fare la copia di sicurezza dei tuoi dati, basandoti su un piano. Ancora meglio, dovresti fare la copia di sicurezza dei tuoi dati e controllarla prima di eseguire un qualsiasi intervento critico, tipo reinstallare il sistema operativo, cambiare il disco, ridimensionare le partizioni, e via discorrendo.

Prevenzione dei disastri¶

Diciamo che ogni giorno tu faccia scrupolosamente le copie di sicurezza su un disco esterno SATA. Un bel giorno, però, ti capita un tempaccio con fulmini. Sei fortunato, a meno che tu non sia come la maggior parte delle persone, che tengono i loro dispositivi esterni collegati al computer.

I disastri che colpiscono localmente possono distruggere tanto, tutto in una volta. Dimenticati dei disastri aerei: fuoco, acqua, bambini e furti sono già abbastanza pericolosi per i nostri dati. Gli incidenti domestici spesso distruggono un’intera stanza o persino l’intera casa.

Così, controllo del disastro significa archiviazione delocalizzata: occasionalmente sposta le tue copie di sicurezza, al piano di sopra, in un’altra casa oppure nel tuo posto di lavoro.

Vi è un’altra buona ragione per separare fisicamente le tue copie di sicurezza: come riportato sopra, il panico spesso porta a errori che causano la distruzione di dati, anche delle copie di sicurezza. Mantenere una copia di sicurezza in un luogo remoto ti darà abbastanza tempo per pensare ed evitare quindi stupidi errori.

Aspetti tecnici delle copie di sicurezza¶

Copia di sicurezza completa: copia completa di tutti i file che sono da salvare. È un”«istantanea» senza storia, che rappresenta una copia totale dei tuoi dati in un punto del tempo.

Copia di sicurezza differenziale: copia dei soli file che hanno subito cambiamenti dall’ultima copia di sicurezza completa. Costituisce un’istantanea di due punti nel tempo: la copia di sicurezza completa e l’ultimo differenziale.

Copia di sicurezza incrementale: copia dei soli file che sono cambiati dall’ultima copia di sicurezza in un gruppo di copie. Forma più istantanee. Puoi ricreare lo stato originale in ogni punto del tempo in cui la copia di sicurezza è stata creata. Questo concetto si avvicina a un sistema di controllo di versione, tranne per il fatto che non è continuo ma è solo a campione.

Fare copie di sicurezza dei dati¶

Il sistema migliore per fare la copia di sicurezza dei dati è:

Esegui una copia di sicurezza completa su un dispositivo esterno di archiviazione.

Verifica l’integrità dei dati e conserva il dispositivo in un luogo sicuro (controllo dei disastri).

Prendi un altro dispositivo di archiviazione per copie di sicurezza frequenti.

Scambia i dispositivi a mesi alterni, dopo averne verificato l’integrità dei dati.

Uno strumento utile per eseguire copie di sicurezza¶

rsync è un fantastico programma per Linux incredibilmente semplice da configurare nelle tue macchine. Anziché avere una sessione FTP tramite script, o qualche altra forma di script per il trasferimento dei file, rsync copia solo le differenze dei file che sono stati veramente cambiati, le comprime e spedisce via ssh per sicurezza, se lo desideri. Sembra uno scioglilingua.

Un ragionevole approccio alle copie di sicurezza per le immagini potrebbe essere:

Crea subito la copia di sicurezza delle immagini importanti (dopo averle scaricate nel PC) su un supporto ottico.

Esegui una copia di sicurezza incrementale quotidiana dello spazio di lavoro.

Esegui copie di sicurezza incrementali settimanali, e cancella le copie integrali della settimana-2 (di due settimane fa).

Esegui copie di sicurezza incrementali mensili, e cancella le copie del mese-2.

Se il dispositivo per le copie di sicurezza non è già fisicamente separato, separalo ora (scambiandolo con un altro dispositivo per la copia di sicurezza).

Questo protocollo cerca di lasciarti il tempo sufficiente per individuare le perdite e recuperare completamente di dati, se necessario, mantenendo allo stesso tempo il volume delle copie di sicurezza sotto il 130% dello spazio di lavoro. Ti ritroverai con una versione giornaliera degli ultimi 7-14 giorni, un’istantanea settimanale per almeno un mese, e un’istantanea di ciascun mese. Qualsiasi ulteriore diradamento andrà fatto a mano dopo una verifica completa.

Dovresti valutare anche dei passaggi per conservare le tue immagini attraverso i cambi della tecnologia e i proprietari.

Allo scopo di far sopravvivere le tue immagini per le prossime due generazioni, è possibile seguire due strategie:

Resta al passo con la tecnologia, non rimanere indietro per più di un paio d’anni.

Salva le tue foto in formati standard aperti e non proprietari.

Resta al passo con la tecnologia¶

Mentre il futuro è fondamentalmente imperscrutabile, il progresso tecnologico sembra certamente proseguire. Ogni 5-8 anni dovresti porti la domanda sulla retrocompatibilità degli attuali sistemi. Meno varianti utilizziamo nel passato, meno domande hanno bisogno di risposte nel futuro.

Ovviamente, ogni volta che cambi il tuo sistema computer (macchina, sistema operativo, applicazioni, DRM) devi di farti sempre le stesse domande. Oggi, se vuoi passare a Windows, ti devi chiedere tre volte se potrai ancora importare le tue foto e, cosa più importante, se sarai sempre capace di spostarle da lì verso un altro sistema o un’altra macchina. Se resti legato a un sistema proprietario, allora esistono buone possibilità che non sarai in grado. Vediamo molte persone che lottano perché Windows applica un regime DRM (gestione di diritti digitali) stretto. Come puoi provare a Windows che sei proprio tu il proprietario dei diritti d’autore sulle tue immagini?

La soluzione a questo problema è usare soltanto standard aperti che sono supportati da più applicazioni.

La virtualizzazione è ora ampiamente disponibile per tutti. Se hai, dunque, un vecchio sistema che è importante per leggere le tue immagini, conservalo, in modo che potrai poi installarlo come una macchina virtuale per un uso futuro.

In alternativa, il consiglio è abbastanza semplice: ogni volta che cambi l’architettura del computer, la tecnologia di memorizzazione e di creazione delle copie di sicurezza o il formato dei tuoi dati, scorri la tua libreria e converti tutto allo standard più recente, se necessario. E rimani con gli standard aperti.

Scalabilità¶

Scalabilità è l’espressione, da maniaco di tecnologia, della possibilità (semplice) di un sistema di essere ridimensionato, che significa sempre essere accresciuto.

Ipotizziamo che hai progettato la scalabilità e salvato la tua raccolta di immagini in un contenitore che vuoi ingrandire in una partizione o un disco separato. Su un sistema Linux puoi quindi copiare e ridimensionare il contenitore in un nuovo disco.

Usa formati di file aperti¶

La breve storia dell’era digitale degli ultimi 20 anni ha dimostrato ancora una volta che i formati proprietari non sono la strada da seguire, se vuoi che i tuoi dati siano intellegibili dopo 10 anni. Microsoft è il fornitore più noto di formati proprietari, grazie alla sua quota dl mercato dominante. Ma altre compagnie potrebbero essere peggiori, perché la loro permanenza nel mercato non è abbastanza lunga o perché hanno soltanto una piccola base di utenti o contribuenti. Nel caso di Microsoft, un utente ha almeno il vantaggio di poter condividere lo stesso problema con molte altre: ciò rende molto più probabile trovare una soluzione a un problema che riguarda i loro formati proprietari. Inoltre è ancora comune che qualsiasi versione della suite di MSOffice non è in grado di leggere correttamente un documento creato con la stessa applicazione di due versioni principali precedenti.

Fortunatamente, i formati immagine normalmente hanno una vita più lunga dei documenti da ufficio, e sono un po” meno soggetti all’obsolescenza.

Gli standard aperti hanno il grosso vantaggio di avere delle specifiche aperte. Anche se nel futuro non ci sarà più un software in grado di leggere un particolare formato di file, qualcuno lo potrà sempre ricreare basandosi solamente sulle specifiche del formato.

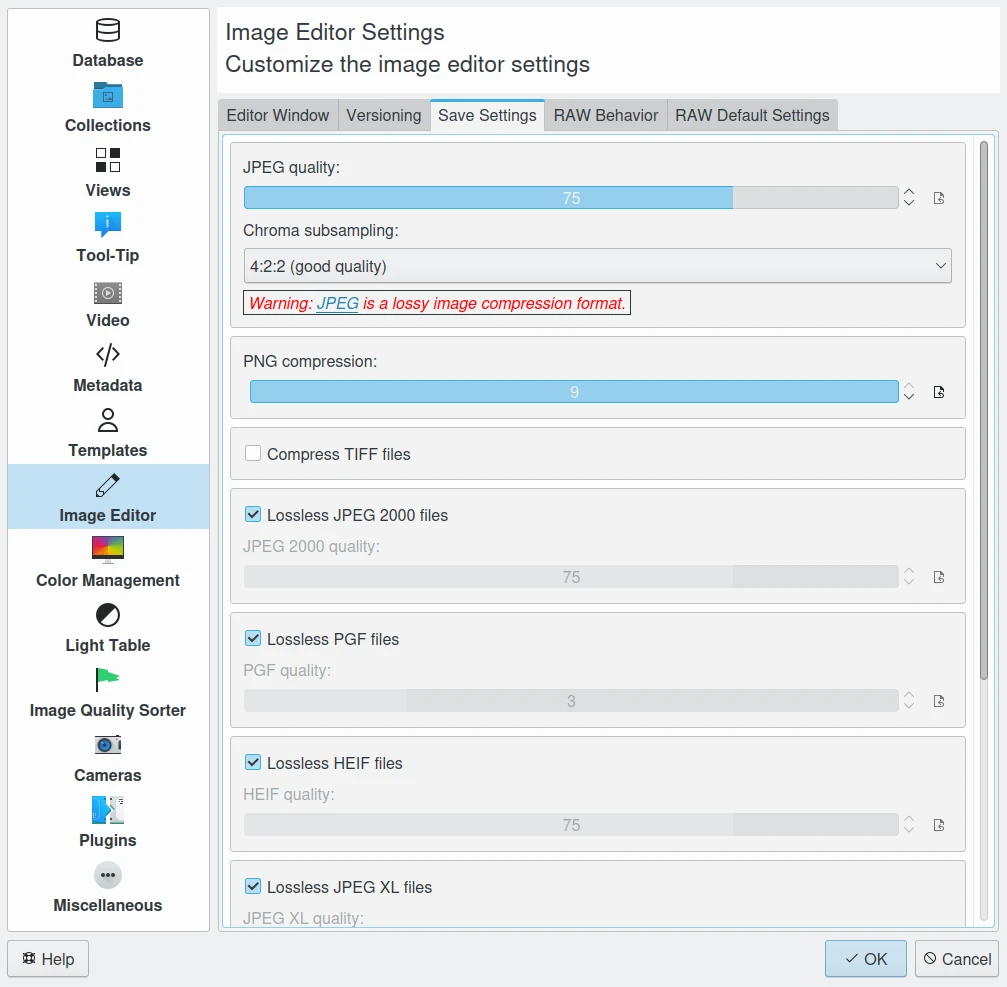

Impostazioni di salvataggio predefinite dell’editor delle immagini di digiKam per i formati comuni delle immagini¶

JPEG è in circolazione da un po” ormai. È un formato che perde dati ogni volta che fai e salvi una versione modificata dell’originale. L’aspetto positivo è che il formato JPEG è molto diffuso, supporta i metadati JFIG, Exif, IPTC, e XMP, ha buoni fattori di compressione e può essere letto da tutti i software di gestione delle immagini. A causa delle sue limitazioni nei metadati, la sua naturale perdita di dati, la sua assenza di trasparenze e la sua profondità di colore di 8bit per canale noi non lo raccomandiamo. Il formato JPEG2000 è migliore, può essere impiegato senza perdita di dati, ma ha una base di utenti meno estesa.

GIF è un formato proprietario con brevetti che sta lentamente scomparendo dal mercato. Non usarlo.

PNG è un formato standard open source, inventato per rimpiazzare GIF, ma fa molto di più. È senza perdita di dati, supporta i metadati XMP, Exif e IPTC, possiede la codifica del colore a 16 bit e la piena trasparenza. PNG può memorizzare i dati della gamma e le informazioni sul colore per una migliore corrispondenza su piattaforme eterogenee. L’aspetto negativo sono le dimensioni relativamente grandi (ma inferiori a TIFF) e la compressione lenta. Lo raccomandiamo.

TIFF è stato largamente accettato come formato per le immagini. TIFF può esistere in forma non compressa oppure in un contenitore che usa un algoritmo (Deflate) di compressione senza perdita di dati. Mantiene un’alta qualità dell’immagine, ma con un file di dimensioni molto più grandi. Alcune fotocamere permettono di salvare le immagini in questo formato. Il problema è che il formato è stato modificato da così tante persone che ora ce ne sono almeno 50 o più varianti, non tutte riconoscibili da tutte le applicazioni.

PGF sta per Progressive Graphics File, ed è un altro formato immagine aperto, anche se non molto conosciuto. Basato su wavelet, consente la compressione sia con perdita di dati, sia senza perdita di dati. PGF è comparabile a JPEG 2000 ma è stato sviluppato pensando alla velocità di compressione/decompressione piuttosto che al rapporto di compressione. Un file PGF appare decisamente migliore di un file JPEG della stessa dimensione, pur risultando molto buono anche nella visualizzazione progressiva. Il formato PGF viene utilizzato internamente da digiKam per memorizzare le miniature compresse nella banca dati. Per ulteriori informazioni sul formato PGF, consulta la pagina web di libPGF

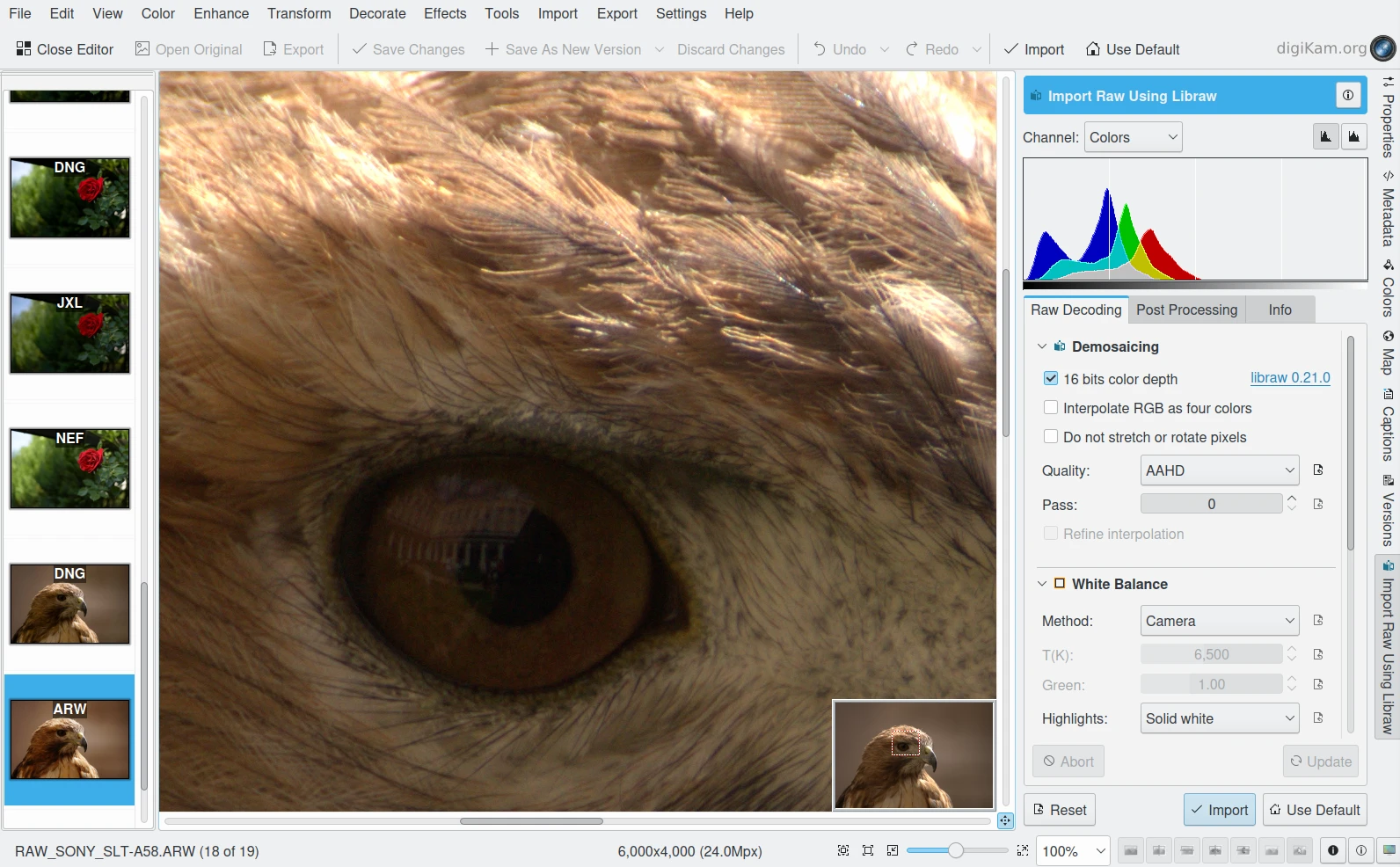

Strumento di importazione RAW dell’editor delle immagini di digiKam¶

Formato RAW. Alcune fotocamere più costose, supportano gli scatti in formato RAW. Il formato RAW non è in realtà uno standard per le immagini, è un formato contenitore che si differenzia in base a ogni marca e modello. Le immagini in formato RAW contengono i dati elaborati il meno possibile dal sensore di immagine della fotocamera digitale o dello scanner. Le immagini in formato RAW vengono a volte chiamate negativi digitali, perché hanno lo stesso ruolo che avevano i negativi nella fotografia chimica tradizionale. Nello specifico, non possono essere utilizzate direttamente come immagine, come il negativo, ma contengono tutte le informazioni necessarie per crearla. Salvare le fotografie nel formato RAW di una fotocamera fornisce una gamma più dinamica e permette di cambiare le impostazioni, ad esempio il bilanciamento del bianco, anche dopo che la fotografia è stata scattata. La maggior parte dei fotografi professionisti usa il formato RAW perché fornisce loro la massima flessibilità. L’aspetto negativo è che i file in formato RAW possono essere davvero grandi.

Raccomandiamo di astenerti dal mantenere un archivio in formato RAW (raccomandiamo invece di scattare foto in formato RAW). Non c’è alcun vantaggio nell’archiviare le immagini in un formato RAW nativo. Questi formati presentano molte varianti e sono tutti proprietari. Ed è molto probabile che nel giro di qualche anno non sarai in grado di usare i tuoi vecchi file RAW. Abbiamo già visto persone cambiare le loro macchine fotografiche, perdere i propri profili di colore e avere grandi difficoltà a lavorare correttamente con i loro vecchi file RAW. Ti suggeriamo invece passare al formato DNG.

DNG, o formato di file Digital Negative, è un formato di immagine RAW gratuito e aperto originariamente progettato da Adobe Systems. DNG era la risposta alla richiesta di unificare il formato di file RAW per le fotocamere. Si basa sul formato TIFF/EP, e impone l’uso dei metadata. Uno sparuto gruppo di produttori di macchine fotografiche ha già adottato DNG. Speriamo che un giorno anche i suoi oppositori principali, Canon e Nikon, lo adottino. Il formato Apple ProRAW, disponibile a partire dall’iPhone 12 Pro Max, si basa su DNG.

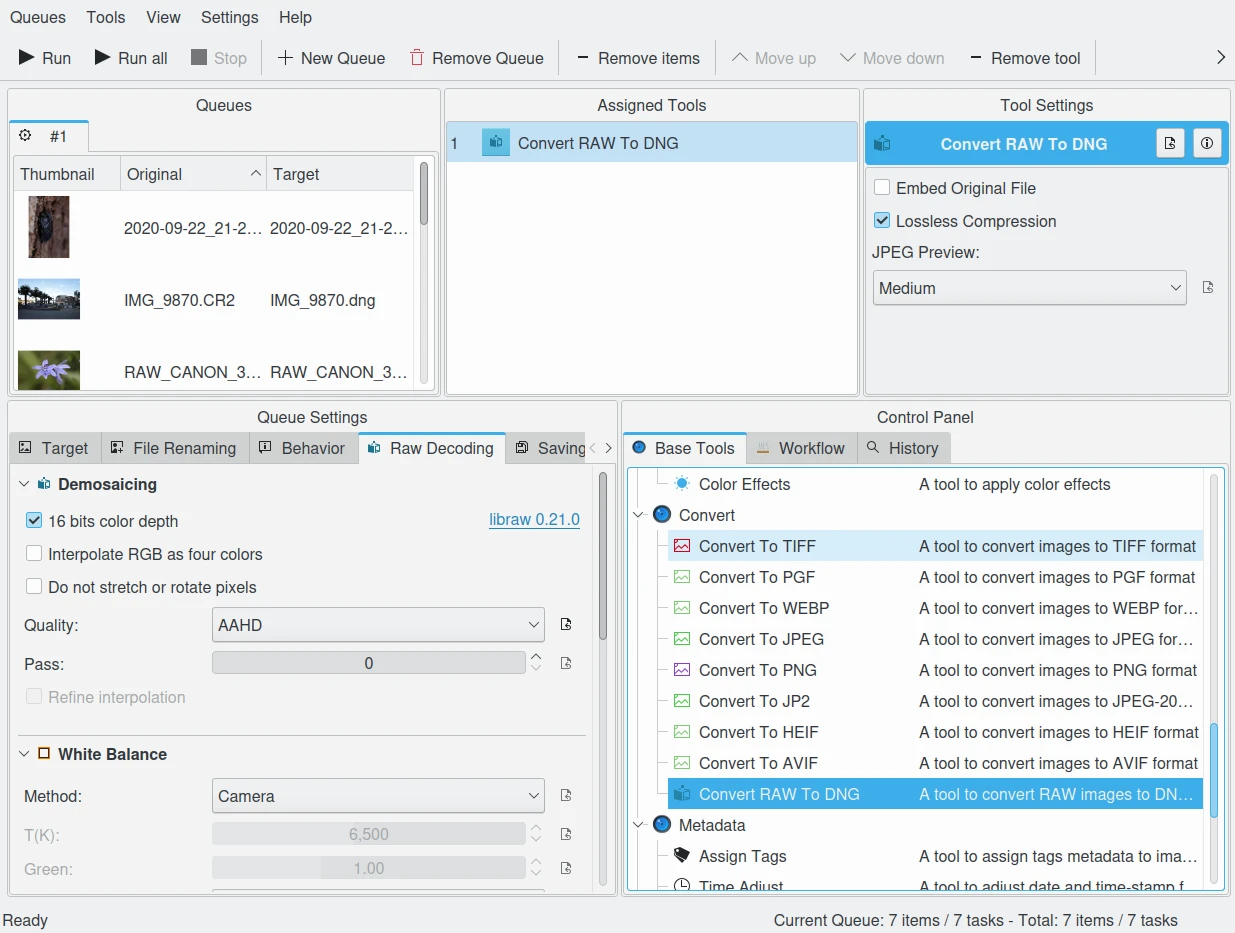

digiKam offre uno strumento per convertire in serie RAW in DNG nel Gestore elaborazione in serie¶

Raccomandiamo vivamente di convertire i file RAW in DNG per l’archiviazione. Nonostante DNG sia stato creato da Adobe, è uno standard aperto e ampiamente adottato dalla comunità open source (il che è un buon indicatore della longevità di un formato). Alcuni produttori hanno già adottato DNG come formato RAW. Ultimo, ma non per importanza, Adobe è al giorno d’oggi la fonte più importante di software per grafica, e naturalmente sostiene la propria invenzione. È un formato di archiviazione ideale, con i dati del sensore RAW conservati come tali nel formato TIFF all’interno del DNG, mitigando il rischio associato ai formati RAW proprietari. Tutto ciò rende la migrazione a un altro sistema operativo un gioco da ragazzi.

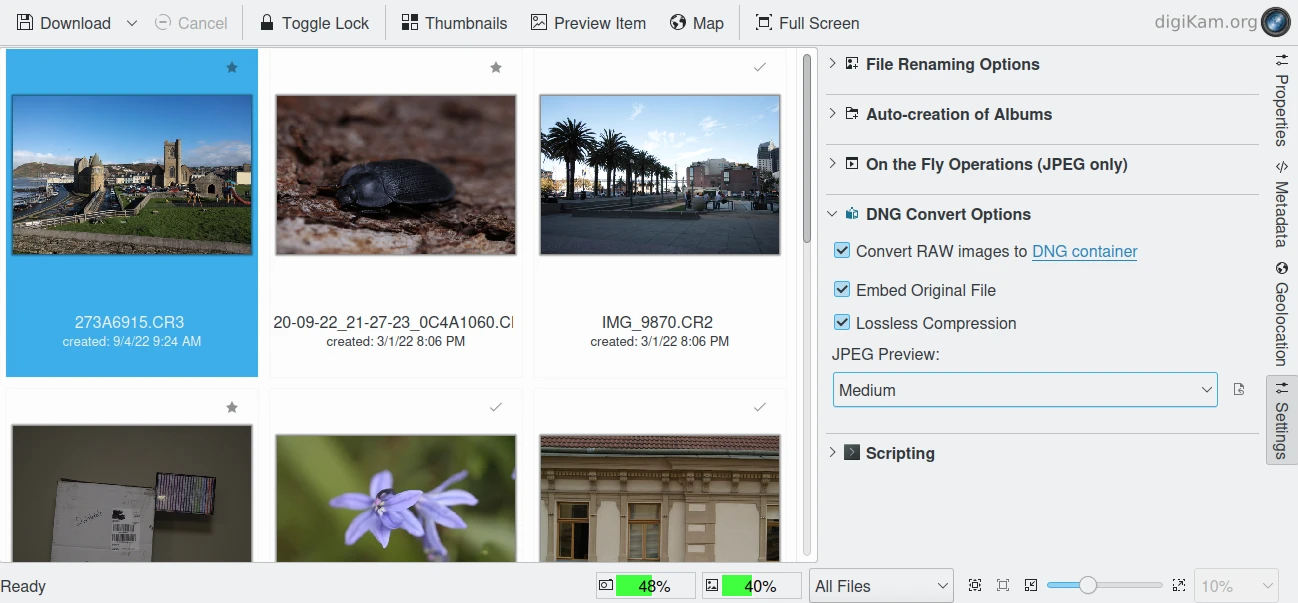

digiKam offre strumenti per convertire RAW in DNG durante lo scaricamento dalla fotocamera¶

XML (Extensible Mark-up Language) o RDF (Resource Description Framework). XML è come HTML, ma laddove HTML si occupa principalmente della presentazione dei dati, XML si occupa della rappresentazione dei dati. Per giunta, XML non è proprietario, è indipendente dal sistema operativo, piuttosto semplice da interpretare, basato su testo ed economico. RDF è la soluzione del WC3 per integrare varie applicazioni, come i cataloghi delle librerie, le directory di respiro mondiale, fonti di notizie, software, come pure raccolte musicali, di immagini ed eventi con l’uso di XML come sintassi di interscambio. Insieme, le specifiche offrono un metodo che utilizza una ontologia leggera basata sul Dublin Core che supporta anche il «Web semantico» (lo scambio facile di conoscenza sul web).

IPTC diventa XMP¶

Questa è probabilmente una delle ragioni per cui, intorno al 2001, Adobe introdusse il suo XML basato sulla tecnologia XMP per sostituire la tecnologia Image Resource Block degli anni “90. XMP è l’acronimo di Extensible Metadata Platform, un misto di XML e RDF. È una tecnologia di etichettatura che permette agli utenti di incorporare i dati su un file all’interno dello stesso file, e le informazioni del file vengono salvate utilizzando l’estensione *.xmp* (che indica l’uso di XML/RDF).

XMP: così come ODF sarà leggibile per sempre (poiché il testo che contiene esso è scritto in chiaro), XMP conserverà i tuoi metadati in un formato XML chiaramente comprensibile. Nessun pericolo di non essere in grado di leggerlo in seguito. Può essere incorporato nei file di immagine o in un file di accompagnamento separato (che Adobe chiama file sidecar). XMP può essere usato nei file PDF, JPEG, JPEG2000, GIF, PNG, HTML, TIFF, Adobe Illustrator, PSD, Postscript, Encapsulated Postscript e video. Nei file JPEG, le informazioni XMP sono normalmente incluse accanto ai dati Exif e IPTC.

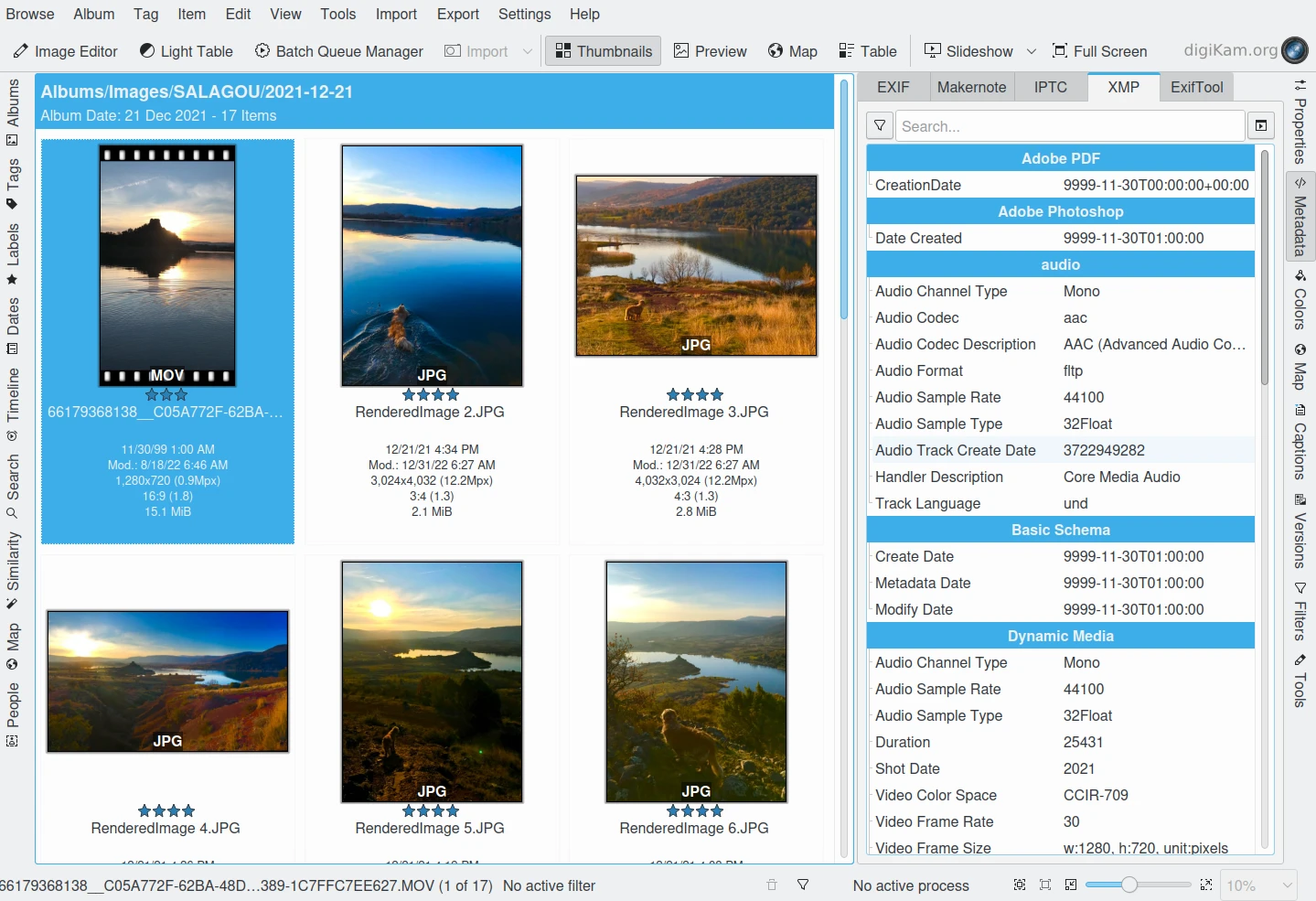

digiKam può visualizzare il contenuto XMP dall’immagine e il video¶

L’incorporazione diretta dei metadati nei file immagine permette di condividere e trasferire facilmente i file tra prodotti, produttori, piattaforme e consumatori, senza perdita dei metadati. I tag di metadati più comunemente registrati nei dati XMP sono quelli della Dublin Core Metadata Initiative, che includono dati come titolo, descrizione, autore e via discorrendo. Lo standard è progettato per essere estensibile e permettere agli utenti di aggiungere metadati personalizzati nei dati XMP. Questo generalmente non permette di incorporare dati binari: ciò significa che se si vogliono trasportare dati binari in XMP, come le miniature, essi devono essere codificati in un formato interpretabile da XML, come Base-64.

Molti fotografi preferiscono tenere per il proprio archivio l’originale dei loro scatti (per lo più in RAW). XMP è adatto a questo approccio, poiché mantiene i metadati separati dai file dell’immagine. Non condividiamo questo punto di vista. Ci potrebbero essere problemi nel collegare il file dei metadati con l’immagine e, come affermato prima, i formati RAW diventeranno obsoleti. Raccomandiamo l’uso di DNG come contenitore, inserendoci tutto all’interno del file.

La Dublin Core Metadata Initiative è un’organizzazione aperta dedita nello sviluppo di standard per i metadati interoperabili in linea che supportano un’ampia gamma di obiettivi e di modelli per il business. Le attività del DCMI includono il lavoro sull’architettura e la modellazione, discussioni e lavoro collaborativo nelle comunità DCMI e nei gruppi di lavoro DCMI, conferenze annuali e workshop, contatti standard e sforzi educativi per promuovere una più ampia accettazione degli standard e delle pratiche sui metadati.

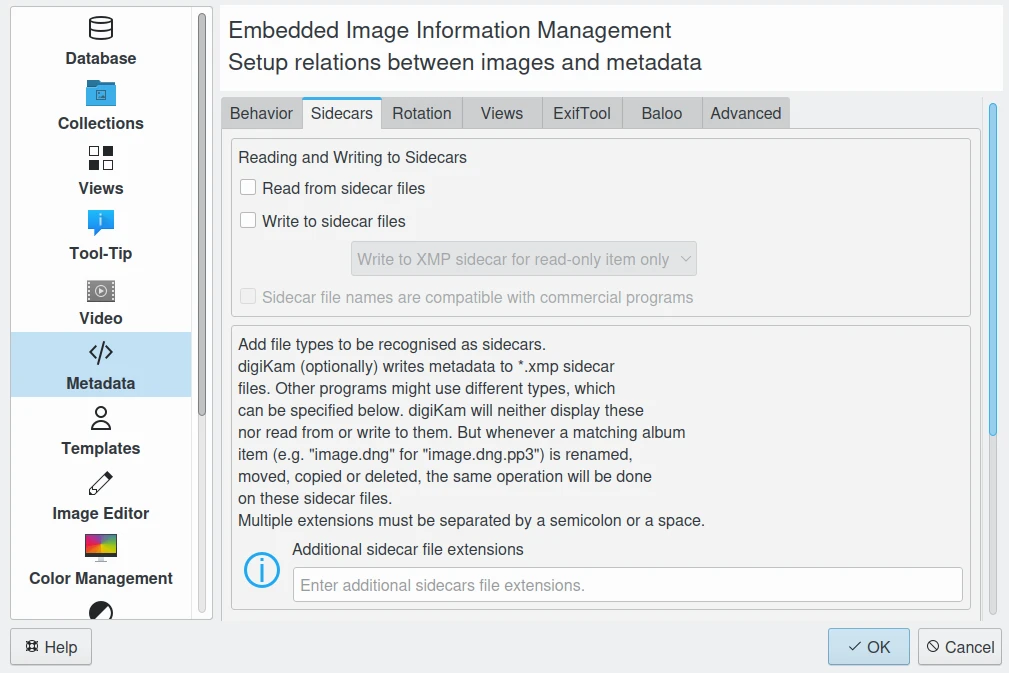

digiKam supporta i file sidecar con molte opzioni dal pannello delle impostazioni¶

Proteggi i tuoi dati¶

Usa scaricatori di sovratensioni (standard UL 1449), possibilmente combinati con un’unità UPS.

Usa memorie ECC per correggere gli errori di memoria (anche solo quando salvi i file).

Controlla i tuoi dischi fissi (temperatura, rumore…), fai copie di sicurezza.

Tieni le copie di sicurezza in un altro posto, chiuso a chiave, usa uno spazio web di archiviazione.

Usa supporti da archivio e masterizzatori.

Non entrare in panico in caso di perdita di dati, spiega il tuo piano di recupero ad un tecnico esperto.

Scegli il tuo filesystem, le tue partizioni e le tue cartelle, per una facile scalabilità del sistema.

Usa standard aperti e non proprietari per gestire e per salvare le tue fotografie.

Fai una revisione tecnica/di migrazione almeno ogni cinque anni.